En medio del furor generado por el auge de DeepSeek, el modelo de inteligencia artificial desarrollado en China que ha desafiado a gigantes como OpenAI y Google, Alibaba ha lanzado su propia apuesta: Qwen2.5-Max, un sistema basado en arquitectura Mixture of Experts (MoE) que, según la compañía, supera a DeepSeek V3 en múltiples benchmarks y se posiciona como un rival de primer nivel en la industria.

La respuesta de Alibaba al fenómeno DeepSeek

Alibaba anunció el lanzamiento de Qwen2.5-Max, un modelo entrenado con más de 20 billones de tokens y optimizado mediante técnicas avanzadas de Ajuste Fino Supervisado (SFT) y Aprendizaje de Refuerzo con Retroalimentación Humana (RLHF). La compañía, que lleva años desarrollando modelos de lenguaje, busca ahora robarle protagonismo a DeepSeek, cuyo reciente éxito ha centrado la atención en los sistemas MoE.

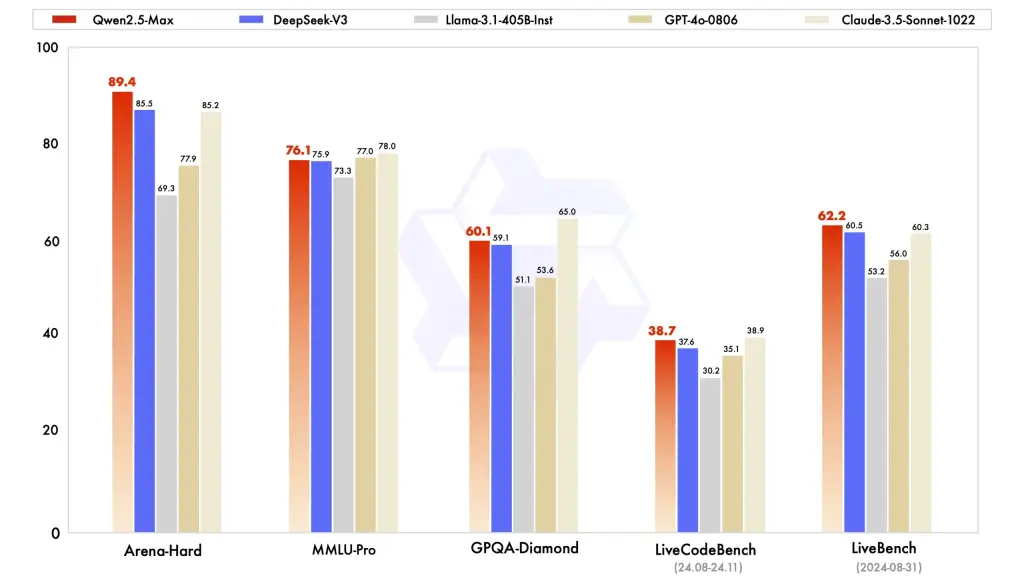

En un comunicado publicado en su cuenta de X (antes Twitter), Alibaba aseguró que Qwen2.5-Max supera no solo a DeepSeek V3, sino también a modelos como GPT-4o de OpenAI y Claude-3.5-Sonnet de Anthropic en pruebas como Arena Hard, LiveBench, LiveCodeBench y GPQA-Diamond, esta última diseñada para evaluar conocimientos académicos complejos a nivel universitario.

«El lanzamiento de DeepSeek V3 ha atraído la atención hacia los modelos MoE, pero nosotros llevamos tiempo construyendo Qwen2.5-Max con datos masivos y metodologías seleccionadas. Ahora ofrecemos un rendimiento superior», destacó la empresa.

La búsqueda de Qwen2.5-Max, la nueva IA de @AlibabaGroup pic.twitter.com/PEtIfHoMBA

— Canal USB (@UsbCanal76361) January 29, 2025

Según Alibaba, su modelo sobresale en tareas que van desde la generación de código hasta la resolución de problemas que requieren conocimientos especializados. En comparación con DeepSeek V3 y otros sistemas de código abierto como Llama-3.1-405B, Qwen2.5-Max demostraría mayor eficacia en escenarios prácticos, como la toma de decisiones y la creación de contenido técnico.

Además, la compañía resalta que su IA integra funciones innovadoras en Qwen Chat, su plataforma pública de chatbot. Los usuarios pueden generar imágenes, videos e incluso artefactos interactivos mediante código JavaScript, como emojis que aparecen al hacer clic en la pantalla.

Al igual que DeepSeek, Qwen2.5-Max utiliza arquitectura MoE, una técnica que divide el modelo en subredes neuronales especializadas («expertos»), cada una capacitada para dominar un tipo de tarea o dato. Una red de enrutamiento selecciona dinámicamente a los expertos más relevantes para cada entrada, optimizando así el rendimiento y reduciendo costos computacionales.

«MoE permite activar solo los expertos necesarios, lo que hace al modelo más eficiente y adaptable», explicó Alibaba. Esta flexibilidad facilitaría, por ejemplo, que Qwen2.5-Max procese tanto lenguaje cotidiano como técnico sin sacrificar velocidad.

Código de Qwen2.5-Max, la IA de @AlibabaGroup pic.twitter.com/F87RgKLIfg

— Canal USB (@UsbCanal76361) January 29, 2025

A diferencia de OpenAI, que restringe el acceso a sus modelos más avanzados, Alibaba ofrece Qwen2.5-Max de forma gratuita a través de Qwen Chat. Los usuarios solo necesitan registrarse con una cuenta de Google o GitHub para utilizarlo como modelo predeterminado, sin costos adicionales.

Mientras DeepSeek emergía como la sorpresa china frente a Occidente, Alibaba aprovecha el momento para reafirmar su posición. Aunque Qwen2.5-Max aún debe demostrar su superioridad en entornos reales, su lanzamiento refleja la intensa competencia en el sector y el creciente peso de China en la carrera tecnológica.

Con ambas compañías apostando por arquitecturas MoE, la batalla no solo se libra en rendimiento, sino en eficiencia y accesibilidad. El mensaje de Alibaba es claro: no subestimen a los gigantes tradicionales.

Así desarrolla un juego Qwen2.5-Max, la IA de @AlibabaGroup pic.twitter.com/Zfgp7X71tk

— Canal USB (@UsbCanal76361) January 29, 2025

Generado por IA