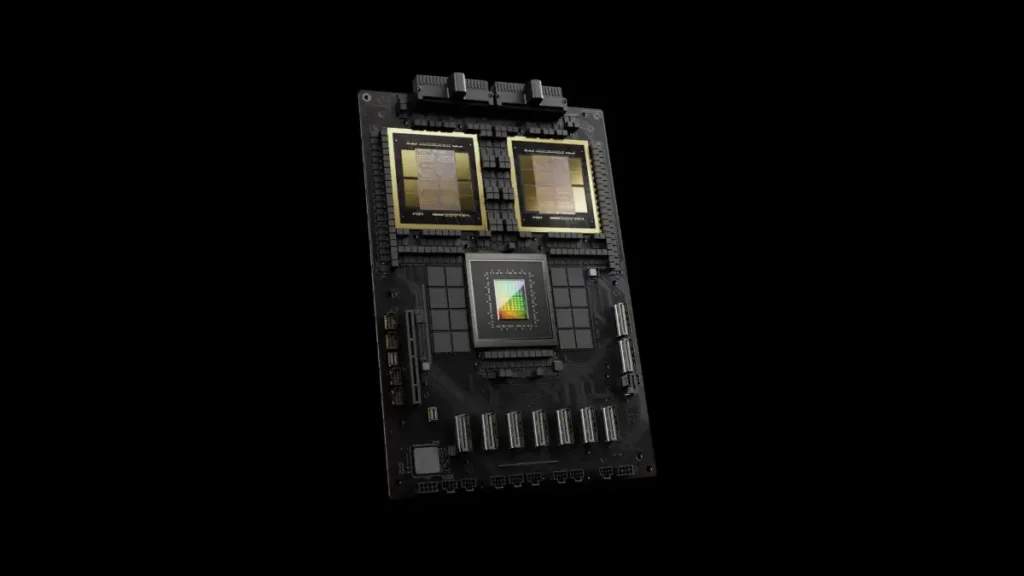

NVIDIA presentó su nueva GPU Blackwell B200 y el superchip Blackwell GB200. Estos dos nuevos componentes prometen revolucionar el entrenamiento de modelos de lenguaje en el campo de la inteligencia artificial.

La GPU B200 destaca por integrar 208.000 millones de transistores, superando ampliamente los 80.000 millones presentes en las gráficas H100 y H200, hasta ahora las más avanzadas de NVIDIA. Este nuevo componente, desarrollado con un proceso de 4 nanómetros de TSMC, ofrece un rendimiento de 20 petaflops FP4 y cuenta con 192 GB de memoria HBM3e, con un ancho de banda de 8 TB por segundo.

Por su parte, el superchip Blackwell GB200 combina dos GPU B200 y una CPU Grace para ofrecer un rendimiento excepcional. Este superchip utiliza una interconexión de chip a chip NVLink de 900 GB por segundo y tiene un consumo energético “ultrabajo”.

Un rack GB200 NVL72, equipado con 36 chips Grace y 72 GPU Blackwell B200, puede ofrecer un rendimiento hasta 30 veces superior al de la misma cantidad de gráficas H100 Tensor Core en tareas de inferencias de modelos de lenguaje de gran tamaño. Según NVIDIA, este rendimiento se logra reduciendo hasta 25 veces su coste y consumo de energía.

Además, NVIDIA asegura que los nuevos SuperPOD, potenciados por el superchip Blackwell GB200, son hasta 4 veces más rápidos para entrenar modelos de inteligencia artificial que las soluciones basadas en la GPU H100. Cada SuperPOD puede incluir hasta 8 sistemas DGX GB200, lo que significa que pueden acumular hasta 288 CPU Grace y 576 GPU Blackwell B200, alcanzando un rendimiento FP4 de 11,5 exaflops.

NVIDIA también ha destacado la escalabilidad de su nueva tecnología. Según la compañía, miles de superchips Blackwell GB200 se pueden conectar con velocidades de hasta 800 Gb/s, gracias a las tecnologías Spectrum-X800 y Quantum-X800 InfiniBand, que también se anunciaron hoy.

La empresa sostiene que las GPU Blackwell B200 y el superchip Blackwell GB200 dan vida a una plataforma que permitirá a empresas y organizaciones crear y ejecutar en tiempo real modelos de IA generativa de billones de parámetros. Jensen Huang, CEO de NVIDIA, afirma que un solo rack GB200 NVL72 soporta modelos de hasta 27 billones de parámetros, una cifra impresionante si consideramos que los modelos de lenguaje más avanzados de la actualidad, como GPT-4, se estiman debajo de los 2 billones de parámetros.

Los grandes quieren a NVIDIA

Grandes empresas del sector tecnológico ya han mostrado su interés en implementar esta nueva tecnología. NVIDIA indica que los productos basados en la plataforma Blackwell estarán disponibles en los próximos meses y que Google Cloud, Microsoft Azure, Oracle y Amazon Web Services serán los primeros proveedores de servicios en la nube que utilizarán instancias potenciadas por este hardware en sus centros de datos.

Aunque no se han brindado mayores detalles, NVIDIA ha comentado que Tesla y xAI también sacarán provecho de los chips Blackwell. “Actualmente, no existe nada mejor que el hardware de NVIDIA para la inteligencia artificial”, dijo Elon Musk sobre el nuevo hardware presentado por la firma estadounidense.

Jensen Huang, CEO de NVIDIA, mostró su satisfacción por el lanzamiento de las GPU Blackwell B200 y el superchip Blackwell GB200. “La IA generativa es la tecnología que define nuestro tiempo. Blackwell es el motor que impulsará esta nueva revolución industrial. Trabajando con las empresas más dinámicas del mundo, haremos realidad la promesa de la IA para todas las industrias”, afirmó.